在当今数字化时代,人工智能(AI)已成为推动社会进步和科技创新的关键力量。然而,对于许多用户而言,如何高效、便捷地利用AI技术仍是一大挑战。特别是在本地化部署方面,许多用户面临着技术门槛高、操作复杂等问题。为此,本文介绍了一种全新的解决方案——通过Ollama与Chatbox的强强联合,实现DeepSeek R1模型的本地化部署。这一方案不仅降低了AI技术的使用门槛,还让用户能够轻松打造出功能强大、个性化十足的AI工具,从而在工作和生活中更加得心应手。

一:🔥 Ollama

🦋 下载 Ollama

🧑💻

https://ollama.com/

Ollama 是一个用于管理和部署机器学习模型的工具。

目前 Ollama 支持 macOS、Linux、Windows,选择相应的系统下载即可。

![图片[1]-Ollama + Chatbox本地化部署DeepSeek R1,轻松打造最强AI工具-趣考网](https://oss.xajjn.com/article/2025/02/12/2039034544.jpg)

🦁 💻 安装后运行软件,在任务栏确认在右上角出现这只 小羊驼🦙 图标

![图片[2]-Ollama + Chatbox本地化部署DeepSeek R1,轻松打造最强AI工具-趣考网](https://oss.xajjn.com/article/2025/02/12/2039034545.jpg)

🦋 选择模型

🧑💻 点击Search models 搜索框,第一条就是 deepseek-r1 模型。

![图片[3]-Ollama + Chatbox本地化部署DeepSeek R1,轻松打造最强AI工具-趣考网](https://oss.xajjn.com/article/2025/02/12/2039034546.jpg)

这里我们发现了多个不同大小的模型,文件大小适配不同的设备

DeepSeek R1提供多个版本,参数量越大,模型通常越强大,但也需要更多的计算资源。

比如1.5B代表有15亿个参数。

![图片[4]-Ollama + Chatbox本地化部署DeepSeek R1,轻松打造最强AI工具-趣考网](https://oss.xajjn.com/article/2025/02/12/2039034547.jpg)

🎁 借助网上大佬们整理的表格供大家参考,来确认你的电脑可以运行哪个模型:

![图片[5]-Ollama + Chatbox本地化部署DeepSeek R1,轻松打造最强AI工具-趣考网](https://oss.xajjn.com/article/2025/02/12/2039034548.jpg)

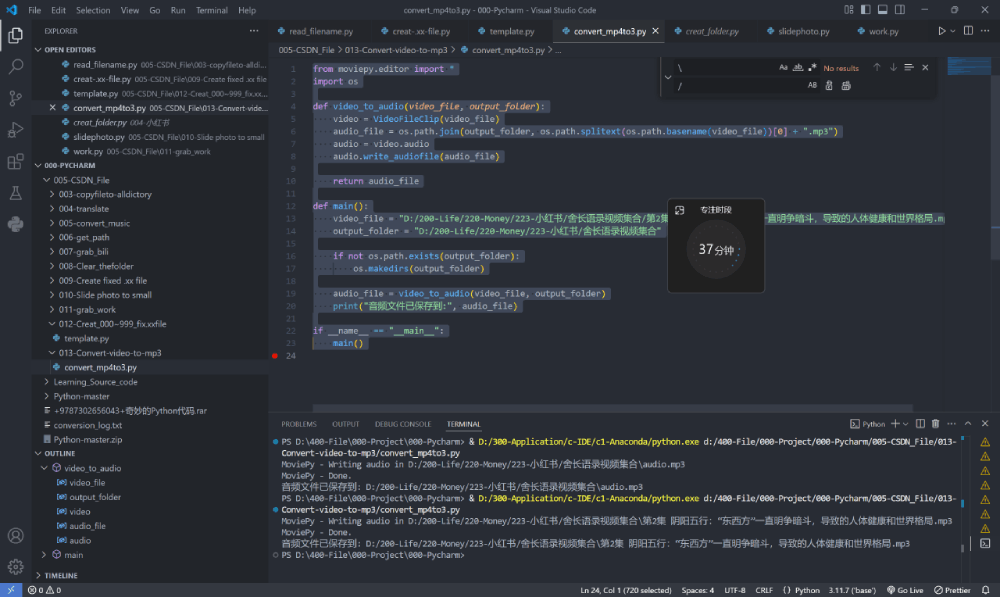

🦋 运行模型

运行模型很简单:确定模型后,复制这条指令到终端里

![图片[6]-Ollama + Chatbox本地化部署DeepSeek R1,轻松打造最强AI工具-趣考网](https://oss.xajjn.com/article/2025/02/12/2039034549.jpg)

💻 当进度条跑满时,恭喜🎉,你的电脑已经拥有了顶级的推理能力

🦋 使用 && 测试

📚 这里我已经提前下好了,使用 ollama 提供的终端指令 ollama list 可以看我们电脑上已经部署了哪些模型,然后使用 ollama run 对应的模型 就可以了

![图片[7]-Ollama + Chatbox本地化部署DeepSeek R1,轻松打造最强AI工具-趣考网](https://oss.xajjn.com/article/2025/02/12/2039044550.jpg)

输入 /bye即可退出

![图片[8]-Ollama + Chatbox本地化部署DeepSeek R1,轻松打造最强AI工具-趣考网](https://oss.xajjn.com/article/2025/02/12/2039044551.jpg)

📚 ollama 命令查看

admin@admindeMacBook-Pro~%ollamaUsage:ollama[flags]ollama[command]AvailableCommands:serveStartollamacreateCreateamodelfromaModelfileshowShowinformationforamodelrunRunamodelstopStoparunningmodelpullPullamodelfromaregistrypushPushamodeltoaregistrylistListmodelspsListrunningmodelscpCopyamodelrmRemoveamodelhelpHelpaboutanycommandFlags:-h,--helphelpforollama-v,--versionShowversioninformationUse"ollama[command]--help"formoreinformationaboutacommand.

🧑💻 虽然这里终端已经可以使用了,但是还是不太方便。

这里就有人要问博主了,你推荐的模型确实挺不错的,但是还是太吃操作了,有没有更加方便的使用方式呢?

有的兄弟有的,像更方便的使用方式那么就是 Chatbox

二:🔥 Chatbox

🧑💻 浏览器搜索 Chatbox 并下载客户端或者网页版都可以

设置语言为中文并保存

![图片[9]-Ollama + Chatbox本地化部署DeepSeek R1,轻松打造最强AI工具-趣考网](https://oss.xajjn.com/article/2025/02/12/2039044552.jpg)

点击设置选择模型为 OLLAMA API

![图片[10]-Ollama + Chatbox本地化部署DeepSeek R1,轻松打造最强AI工具-趣考网](https://oss.xajjn.com/article/2025/02/12/2039044553.jpg)

为了确保可以连接到本地服务,大家按照提供的教程设置一下,不同的操作系统设置不太一样,然后选择 R1模型并保存 连接到本地服务教程跳转

![图片[11]-Ollama + Chatbox本地化部署DeepSeek R1,轻松打造最强AI工具-趣考网](https://oss.xajjn.com/article/2025/02/12/2039044554.jpg)

🦁 现在你就可以在 浏览器/客户端 上流畅的使用 R1 了。

🦋 创建你的专属 GPTs

🧑💻 点击我的搭档,创建搭档,给ai角色设定人格,你也可以选择现有的搭档,一个资深的行业专家就出现了。

![图片[12]-Ollama + Chatbox本地化部署DeepSeek R1,轻松打造最强AI工具-趣考网](https://oss.xajjn.com/article/2025/02/12/2039044555.jpg)

三:🔥 共勉

😋 以上就是我对 DeepSeek R1本地化部署 Ollama + Chatbox 打造最强 AI 工具 的理解,觉得这篇博客对你有帮助的,可以点赞收藏关注支持一波~

总结

通过本文的详细介绍,我们了解了如何利用Ollama与Chatbox进行DeepSeek R1模型的本地化部署,从而打造出强大的AI工具。这一过程中,我们见证了Ollama作为模型管理工具的高效与便捷,以及Chatbox在提供用户友好界面方面的出色表现。通过这一方案的实施,用户不仅能够轻松拥有属于自己的AI助手,还能根据实际需求进行个性化定制,实现AI技术的最大化利用。展望未来,随着AI技术的不断发展和本地化部署方案的持续优化,我们有理由相信,AI将为更多用户带来前所未有的便捷与智能体验。