在当今人工智能技术飞速发展的时代,大语言模型已成为众多应用场景中的核心组件。然而,如何高效地调用和管理这些模型,特别是本地部署的大语言模型,一直是开发者面临的挑战。为了解决这个问题,Ollama应运而生。Ollama是一个专为Python开发者设计的库,它提供了简洁而强大的API接口,使得调用本地大语言模型变得前所未有的轻松。无论是进行文本生成、问题回答,还是构建复杂的AI应用,Ollama都能为开发者提供强有力的支持。本文将详细介绍Ollama的安装、使用、自定义参数设置、流式生成、错误处理以及与其他工具的集成,帮助开发者更好地利用这一利器,释放大语言模型的巨大潜力。

前言

ollama是一个用于调用本地大语言模型(Large Language Models,LLMs)的 Python 库,旨在提供简单、高效的 API 接口,以便开发者能够方便地与本地的大语言模型进行交互。以下是关于如何在 Python 中使用ollama库的详细介绍。

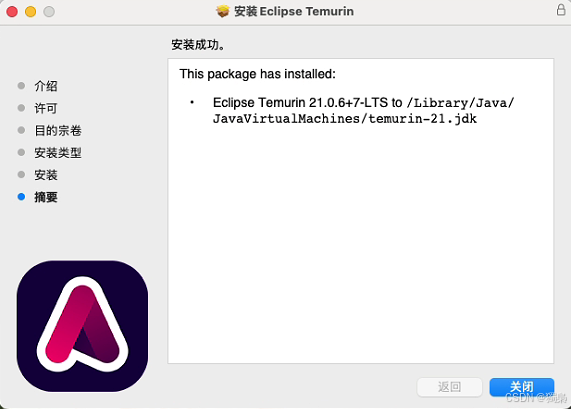

1. 安装 Ollama

在使用库之前,请确保安装了ollama。你可以通过以下命令安装:

pipinstallollama

如果你尚未安装 Python 的包管理工具pip,可以参考官方文档安装它。

2. Ollama 的主要功能

ollama提供了与本地大语言模型(如 llama 或其他模型)交互的简单方法,主要是通过 API 调用模型来生成文本、回答问题等。

3. 使用 Ollama 的基本示例

以下是ollama的基本用法。

3.1 导入库

在 Python 脚本中,首先需要引入ollama:

importollama

3.2 使用 Ollama 调用模型

Ollama 的核心功能是调用本地模型进行推理和生成。你可以通过以下方式调用模型:

生成文本示例

以下是一个简单的生成文本的例子:

importollama#调用Ollama使用大语言模型response=ollama.generate(model="llama",#使用的模型名称prompt="你好,请简单介绍一下Python语言的特点。")#打印生成的内容print(response)

解析模型输出

返回的response通常是一个字符串,表示模型生成的结果。你可以对其进一步处理,比如格式化输出或存储到文件中。

3.3 设置自定义参数

调用模型时,可以传递一些自定义参数来调整模型的行为,比如最大生成长度、生成的温度等。

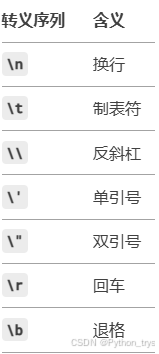

支持的参数

以下是一些常见的参数:

model:指定模型的名称(如 “llama” 等)。prompt:输入提示。temperature:影响生成内容的随机性,值范围为 0 到 1。max_tokens:限制生成的最大 token 数量。

示例:自定义参数

response=ollama.generate(model="llama",prompt="为我写一首关于春天的诗。",temperature=0.7,#生成时的随机性max_tokens=100#限制生成的最大长度)print(response)

3.4 使用自定义模型

如果你已经在本地训练了自定义模型,或者下载了其他模型,可以通过指定模型路径来使用它。

response=ollama.generate(model="/path/to/your/model",#指定本地模型路径prompt="如何学习机器学习?")print(response)

4. 集成流式生成

在某些场景下,你可能希望逐步接收模型生成的结果,而不是等待全部生成完成。这是通过流式生成(Streaming)实现的。

forchunkinollama.stream(model="llama",prompt="逐步生成一段关于人工智能的文章。"):print(chunk,end="")

在流式生成中,模型会逐步返回生成结果的部分内容,你可以实时处理这些结果。

5. 错误处理

调用模型时,可能会遇到错误(例如模型文件路径不正确、请求超时等)。可以通过捕获异常来处理这些错误。

try:response=ollama.generate(model="llama",prompt="请解释什么是大语言模型。")print(response)exceptExceptionase:print(f"发生错误:{e}")6. 高级用法:与其他工具集成

ollama可以与其他工具(如Flask、FastAPI)结合,用于构建自己的 AI 应用。

示例:构建一个简单的 Flask 服务

以下代码展示了如何使用 Flask 构建一个简单的 Web 应用,调用 Ollama 进行生成:

fromflaskimportFlask,request,jsonifyimportollamaapp=Flask(__name__)@app.route(\'/generate\',methods=[\'POST\'])defgenerate():data=request.jsonprompt=data.get("prompt","")try:#调用Ollamaresponse=ollama.generate(model="llama",prompt=prompt,max_tokens=100)returnjsonify({"response":response})exceptExceptionase:returnjsonify({"error":str(e)}),500if__name__==\'__main__\':app.run(debug=True)使用 Postman 或其他工具向/generate端点发送 POST 请求:

{"prompt":"Python的主要优点是什么?"}返回结果会是模型生成的回答。

7. 注意事项

模型兼容性:确保本地安装的模型与

ollama支持的格式兼容。硬件要求:大型语言模型通常需要较高的硬件性能(特别是 GPU 支持)。在调用本地模型时,请确保你的环境足够满足计算需求。

版本更新:定期检查

ollama的版本更新,获取最新功能和优化。

8. 参考文档

有关更多详细用法和配置选项,可以参考ollama的官方文档或相关资源。

官网文档链接(如果有):请搜索

ollama的官方资源。社区支持:可以通过 GitHub 或开发者社区寻求帮助。

总结

通过本文的介绍,我们深入了解了Ollama这一Python库在调用本地大语言模型方面的独特优势。Ollama不仅提供了简单易用的API接口,还支持丰富的自定义参数设置和流式生成功能,使得开发者能够灵活地控制模型的行为,满足多样化的应用需求。同时,Ollama还具备出色的错误处理能力和与其他工具的集成能力,进一步提升了其在实际应用中的价值。相信随着Ollama的不断发展和完善,它将成为更多开发者心中的首选工具,为人工智能技术的普及和应用贡献更大的力量。