在当今数字化时代,随着人工智能技术的飞速发展,越来越多的企业和个人开始寻求高效、安全的数据处理与分析解决方案。DeepSeek,作为一款功能强大的AI工具,为用户提供了精准的数据搜索与分析能力。然而,面对服务器繁忙时的访问限制以及日益严峻的隐私保护问题,许多用户开始考虑将DeepSeek部署至本地环境。本地部署不仅能够有效缓解服务器压力,避免高峰期访问拥堵,还能确保数据的私密性与安全性,让用户在完全掌控的环境中享受DeepSeek带来的高效与便捷。本文将为您提供一份详尽的DeepSeek本地部署指南,帮助您轻松实现这一目标,让AI技术更好地服务于您的业务需求。

前文

由于官网deepseek老是出问题

![图片[1]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595912.jpg)

所以我决定本地部署deepseek

很简单,不需要有什么特殊技能

正文开始

Ollama

首先到这个ollama的官网

goto-Ollama

![图片[2]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595913.jpg)

然后点击中间这个大大的Download

![图片[3]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595914.jpg)

然后再次点击中间这个大大的Download for Windows

![图片[4]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595915.jpg)

等待下载完成

![图片[5]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595916.jpg)

下载完成

![图片[6]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595917.jpg)

完成后去自己的下载目录文件夹里找下载好的文件,双击打开

![图片[7]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595918.jpg)

点击Install

![图片[8]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595919.jpg)

等待安装完成

![图片[9]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595920.jpg)

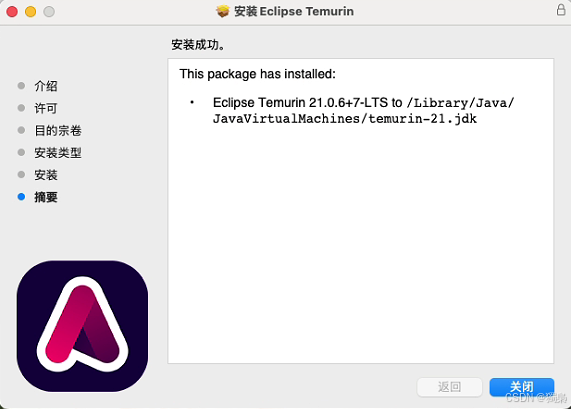

安装完成

![图片[10]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595921.jpg)

![图片[11]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595922.jpg)

安装完成后查看任务栏向上小箭头

羊驼图标就是ollama的进程

然后进行下一步(不要关ollama进程)

ChatBoxAI

打开它的官网

goto-ChatBoxAI

![图片[12]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595923.jpg)

然后点击这个免费下载 (for Windows)

![图片[13]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595924.jpg)

下载开始,等待下载完成

![图片[14]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595925.jpg)

下载完成

打开自己下载文件夹

![图片[15]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595926.jpg)

双击打开下载好的文件

![图片[16]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595927.jpg)

下一步

![图片[17]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595928.jpg)

选个安装位置,点浏览

![图片[18]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595929.jpg)

然后就会打开这个

![图片[19]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595930.jpg)

在里面找好自己的目录,点确定

![图片[20]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595931.jpg)

就会跳回这个界面,点安装

![图片[21]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595932.jpg)

等待安装完成

![图片[22]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595933.jpg)

安装完成后,点完成,稍等一会

![图片[23]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595934.jpg)

就会出现这个界面(这就是以后跟deepseek对话的地方),关了它进行下一步骤

DeepSeek-R1

拉取模型需要在命令行里操作

同时按下Win+R启动运行命令窗口

![图片[24]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595935.jpg)

输入cmd

![图片[25]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595936.jpg)

回车

![图片[26]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595937.jpg)

出现这个(命令提示符)窗口,然后输入以下命令

ollama--version

![图片[27]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595938.jpg)

然后就会出现如上提示

![图片[28]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595939.jpg)

如果是这样的,那就说明你没输对命令,如果反复检查是输对了,那你只能回到Ollama章节把那一章的内容重来一遍了

goto-Ollama

然后再次回到Ollama的官网(不要关闭命令提示符)

![图片[29]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595940.jpg)

点击Models(左上角)

![图片[30]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595941.jpg)

然后自己选自己的AI,一般就是第一个显示的那个AI-deepseek-r1

点击deepseek-r1

![图片[31]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595942.jpg)

点击下拉框选择适合自己的蒸馏版

![图片[32]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595943.jpg)

选择哪个呢,在Decide章节,自行阅读后选择

![图片[33]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595944.jpg)

选好之后点击上图红框中的copy按钮

![图片[34]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595945.jpg)

回到命令提示符中,点击右键复制内容

![图片[35]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595946.jpg)

好了之后回车

![图片[36]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595947.jpg)

等待拉取模型

![图片[37]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595948.jpg)

模型拉取成功(这里的success表示成功)

然后在命令行里会出现Send a message字样,然后不用管它了

下一步

组装

![图片[38]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0324595949.jpg)

打开桌面上的ChatBoxAI

![图片[39]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0325005950.jpg)

点击设置

![图片[40]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0325005951.jpg)

打开模型提供方下拉框

![图片[41]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0325005952.jpg)

选择上图红框中这个Ollama API

![图片[42]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0325005953.jpg)

打开模型下拉框

![图片[43]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0325005954.jpg)

可以看到这里有我们刚刚拉取的deepseek,选择它

![图片[44]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0325005955.jpg)

保存

![图片[45]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0325005956.jpg)

这里也变成自己刚刚拉取的AI了

然后输入一个试试

![图片[46]-DeepSeek 本地部署指南:解决服务器繁忙和隐私问题-趣考网](https://oss.xajjn.com/article/2025/02/19/0325005957.jpg)

以后自己打开ChatBoxAI就可以开始对话了

关闭会自己杀死AI进程

Decide

CPU: 至少 8 核,推荐 16 核或以上。

GPU: 至少 16GB 显存,推荐 24GB 或以上(如 NVIDIA RTX 3090、A100 等)。

内存: 至少 32GB,推荐 64GB 或以上。

存储: 至少 100GB SSD,推荐 NVMe SSD 以加快加载速度。

小型蒸馏版: 适合低资源环境,显存需求约 8GB,内存需求约 16GB。(1.5b、7b、8b)

中型蒸馏版: 显存需求约 16GB,内存需求约 32GB。(14b)

大型蒸馏版: 显存需求约 24GB,内存需求约 64GB。(32b)

需求配置更高的蒸馏版不推荐个人拉取本地部署使用

实际配置可以更低,不过可能会降低配置根据配置自己选择即可

好了,至此就完成了deepseek的本地部署了

总结

通过本文的介绍,我们详细阐述了DeepSeek本地部署的全过程,从准备工作到具体实施,每一步都力求详尽且易于理解。本地部署DeepSeek不仅能够有效解决服务器繁忙时的访问问题,还能显著提升数据处理的私密性与安全性。我们提供了关于Ollama、ChatBoxAI的安装指南以及DeepSeek-R1模型的拉取方法,确保用户能够顺利搭建起本地环境。同时,硬件配置建议的提出,也为用户评估自身设备是否满足部署要求提供了参考。相信通过本文的指引,您将能够轻松掌握DeepSeek本地部署的技巧,让AI技术更加贴近您的实际需求,为业务发展注入新的动力。