2024 年 5 月 7 日,RWKV 开源基金会宣布正式向全球开源 RWKV-6-World 7B 模型。

相比 1 月 18 日开源的 RWKV-5-World 7B 模型,最新发布的 RWKV-6-World 7B 模型不仅升级了模型架构,还在训练过程中额外增加了 1.4T tokens 语料。

基准测试和实际任务的结果显示:RWKV-6-World 7B 模型在多语言、指令遵循和材料总结等复杂任务上的表现更出色。

注意:目前开源发布的 RWKV 模型均为基底模型。基底模型具备一定的指令和对话能力,但未针对任何任务作优化。因此,基底模型在特定任务上的表现并不代表 RWKV 模型最优水准。

如果希望 RWKV 模型在某种类型的任务上表现良好且稳定,建议使用此类任务的数据集对 RWKV 模型进行微调训练。

目前我们已发布一些基于 RWKV 基底模型对特定任务进行微调训练的教程,可以点击下方链接浏览微调文档:

- RWKV 模型保姆级微调教程

彭博:State-tuning:RWKV的独特alignment方法

推荐使用 state tuning 方法进行 RWKV 微调训练。

评测数据

本次模型基准测试涵盖了 13 款接近 7B 参数规模的开源大语言模型,包括 RWKV 系列中的前代架构,如 RWKV-4 和 RWKV-5。

在测试中,英语的性能测试将通过 12 个独立的基准测试来衡量大模型在常识推理和世界知识等英语内容上的表现。

多语言能力的评估中,则采用了 xLAMBDA、xStoryCloze、 xWinograd 和 xCopa 四种基准测试,深度探索了评估模型在多语言环境中的逻辑推理、故事理解、歧义解决和因果推理能力。

![图片[1]-RWKV-6-World 7B 模型于 5 月 7 日正式开源发布-趣考网](https://oss.q2k.com/article/2024/05/08/203233511.jpg)

可以看到,相对此前发布的 RWKV-5-World 7B 模型,RWKV-6-World 7B 的英文性能和多语言性能都获得较大提升。 这一现象不仅凸显了 RWKV-6 模型架构带来的性能优化,也展示了 RWKV 模型的 data scaling 性能。

值得注意的是,我们在训练 RWKV 模型时并未加入任何基准测试的训练集。换言之,我们没有为获取更佳的评分结果而进行特殊优化。因此,RWKV 模型的能力实际上是比它的评分排行更强的。

Uncheatable Eval

我们也对新模型进行了 Uncheatable Eval(不可作弊的模型评测)。 Uncheatable Eval 会使用最新的 arXiv 论文和新闻文章等实时语料库,以此来评估语言模型的真实建模能力和泛化能力。

有关 Uncheatable Eval 的详细介绍,可参见此文章: RWKV在“不可作弊的模型评测”中获得良好成绩 。

此次 Uncheatable Eval 评测选取了常见的 9 款开源 7B 参数模型,具体评分如下:

![图片[2]-RWKV-6-World 7B 模型于 5 月 7 日正式开源发布-趣考网](https://oss.q2k.com/article/2024/05/08/203234512.jpg)

可以看到,流行的开源 7B 模型在 Uncheatable Eval 的评分较为接近,RWKV-6-World 7B 在此次测评中排行第三。

排行前二的 Llama-3-8B 和 Mistral-7B-v0.1 ,其训练数据集比 RWKV 系列模型要大得多(Llama-3-8B 为 15T ,Mistral-7B-v0.1 传闻在 7B 左右)。

需要额外说明的是:mamba-7b-rw 模型训练时使用的 refinedweb 数据集不包含代码语料,故影响了评测的成绩。

模型试玩 & 下载

在线 Demo 体验:https://huggingface.co/spaces/BlinkDL/RWKV-Gradio-2

下载地址:https://huggingface.co/BlinkDL/rwkv-6-world/blob/main/RWKV-x060-World-7B-v2.1-20240507-ctx4096.pth

💡由于 Hugging Face 的在线 Demo 是续写模式,如果你在 RWKV-Gradio 中体验 RWKV-6 7B 模型,我们建议您按以下两种格式输入提示词(prompts) :

User: hiAssistant: Hi. I am your assistant and I will provide expert full response in full details. Please feel free to ask any question and I will always answer it.User: (你的问题,比如“東京で訪れるべき素晴らしい場所とその紹介をいくつか挙げてください。” )Assistant:

或者:

Instruction: (你希望模型进行什么操作,比如:Write a story using the following information.)Input:(提供给模型用于操作的材料,比如:A man named Alex chops a tree down.)Response:

具体用法可参考下列“任务表现”板块内容:

任务表现

多语言翻译+Json 格式输出

![图片[3]-RWKV-6-World 7B 模型于 5 月 7 日正式开源发布-趣考网](https://oss.q2k.com/article/2024/05/08/203234513.jpg)

创作/生活助手任务

![图片[4]-RWKV-6-World 7B 模型于 5 月 7 日正式开源发布-趣考网](https://oss.q2k.com/article/2024/05/08/203234514.jpg)

多语言互译任务

日语-英语

![图片[5]-RWKV-6-World 7B 模型于 5 月 7 日正式开源发布-趣考网](https://oss.q2k.com/article/2024/05/08/203234515.jpg)

英语-西班牙语

![图片[6]-RWKV-6-World 7B 模型于 5 月 7 日正式开源发布-趣考网](https://oss.q2k.com/article/2024/05/08/203234516.jpg)

理解对话问答

![图片[7]-RWKV-6-World 7B 模型于 5 月 7 日正式开源发布-趣考网](https://oss.q2k.com/article/2024/05/08/203234517.jpg)

外卖评论情感分析(多语言)

中文:

![图片[8]-RWKV-6-World 7B 模型于 5 月 7 日正式开源发布-趣考网](https://oss.q2k.com/article/2024/05/08/203234518.jpg)

英文:(真的超级好吃,让我想起了家的感觉):

![图片[9]-RWKV-6-World 7B 模型于 5 月 7 日正式开源发布-趣考网](https://oss.q2k.com/article/2024/05/08/203234519.jpg)

繁体中文:

![图片[10]-RWKV-6-World 7B 模型于 5 月 7 日正式开源发布-趣考网](https://oss.q2k.com/article/2024/05/08/203234520.jpg)

法语(真的超级好吃,香脆多汁,让我想起了家的感觉):

![图片[11]-RWKV-6-World 7B 模型于 5 月 7 日正式开源发布-趣考网](https://oss.q2k.com/article/2024/05/08/203234521.jpg)

机器阅读理解

![图片[12]-RWKV-6-World 7B 模型于 5 月 7 日正式开源发布-趣考网](https://oss.q2k.com/article/2024/05/08/203234522.jpg)

新模型预告

我们正在训练 RWKV-6 14B v2.1 模型, 预计在 5 月底或 6 月初完成训练并发布。 v 2.1 系列模型使用 2.5 T tokens 训练数据 , 后续我们将补充 3T 语料(共 5.5T tokens)重训练 RWKV-6 系列 7B 和 14B 模型,将其升级成 V3 版本。

我们将在完成升级的第一时间与大家分享新模型。

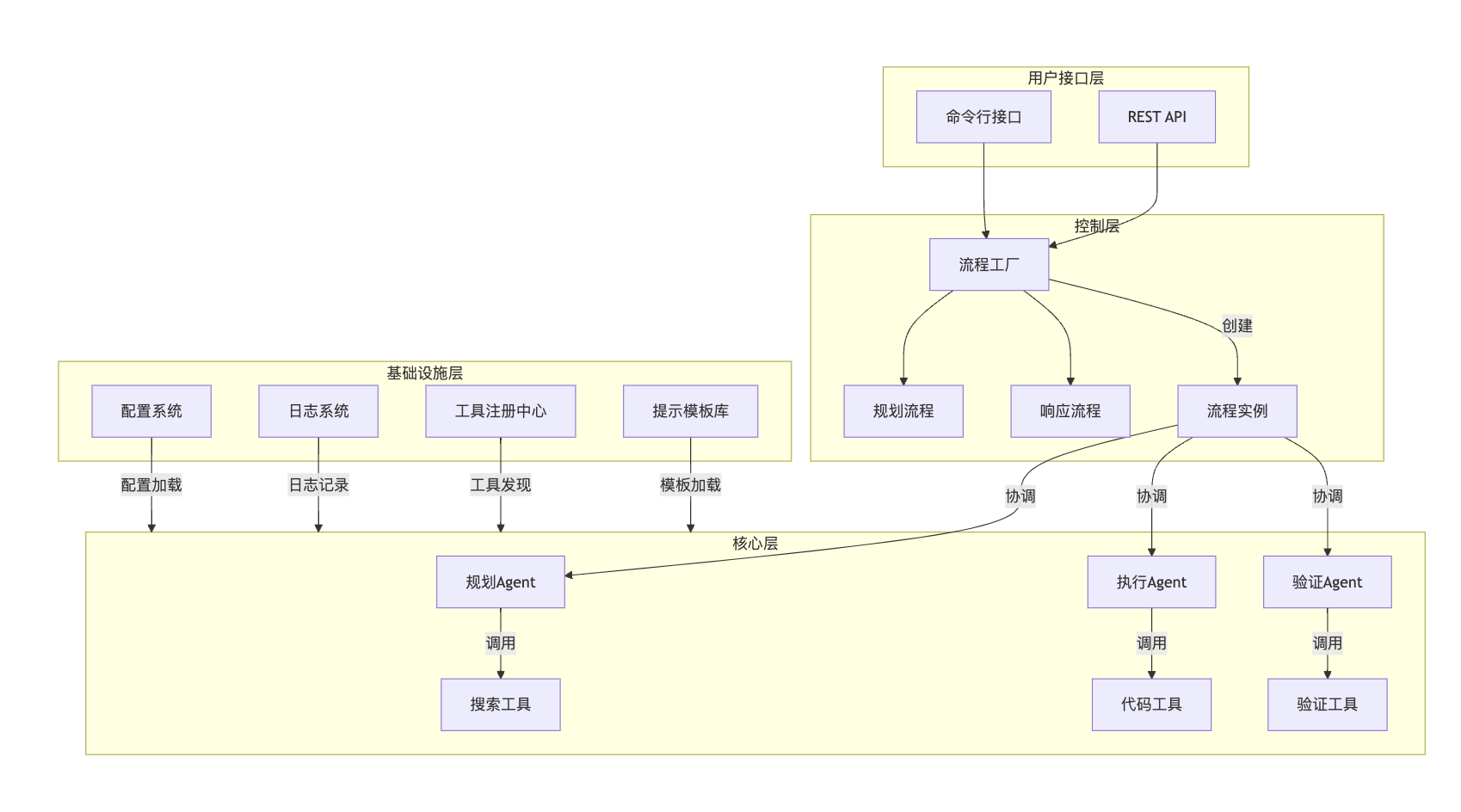

RWKV 模型介绍

RWKV 是一种创新的深度学习网络架构,它将 Transformer 与 RNN 各自的优点相结合,同时实现高度并行化训练与高效推理,时间复杂度为线性复杂度,在长序列推理场景下具有优于 Transformer 的性能潜力。 RWKV 模型架构论文:

- RWKV 4: https://arxiv.org/abs/2305.13048

- RWKV-5/6(Eagle & Finch): https://arxiv.org/abs/2404.05892

RWKV 模型的最新版本是 RWKV-6 ,架构图如下:

![图片[13]-RWKV-6-World 7B 模型于 5 月 7 日正式开源发布-趣考网](https://oss.q2k.com/article/2024/05/08/203234523.jpg)

相对 Transformer 架构,RWKV 架构的推理成本降低 2~10 倍,训练成本降低 2~3 倍。

加入 RWKV 社区

RWKV 官网:https://www.rwkv.com/

QQ 频道:https://pd.qq.com/s/9n21eravc