幻方量化旗下组织深度求索发布了第二代开源 MoE 模型:DeepSeek-V2。

![图片[1]-DeepSeek 发布全球最强开源 MoE 模型-趣考网](https://oss.q2k.com/article/2024/05/08/203534543.jpg)

据介绍,在目前大模型主流榜单中,DeepSeek-V2均表现出色:

中文综合能力(AlignBench)开源模型中最强,与GPT-4-Turbo,文心4.0等闭源模型在评测中处于同一梯队

英文综合能力(MT-Bench)与最强的开源模型LLaMA3-70B同处第一梯队,超过最强MoE开源模型Mixtral 8x22B

知识、数学、推理、编程等榜单结果也位居前列

支持128K上下文窗口

![图片[2]-DeepSeek 发布全球最强开源 MoE 模型-趣考网](https://oss.q2k.com/article/2024/05/08/203534544.jpg)

各大模型API或Chat版本效果对比

此外,DeepSeek-V2 在模型架构也进行创新,采用了自研的 MLA(Multi-head Latent Attention)和 Sparse 结构,可大幅减少模型计算量、推理显存。

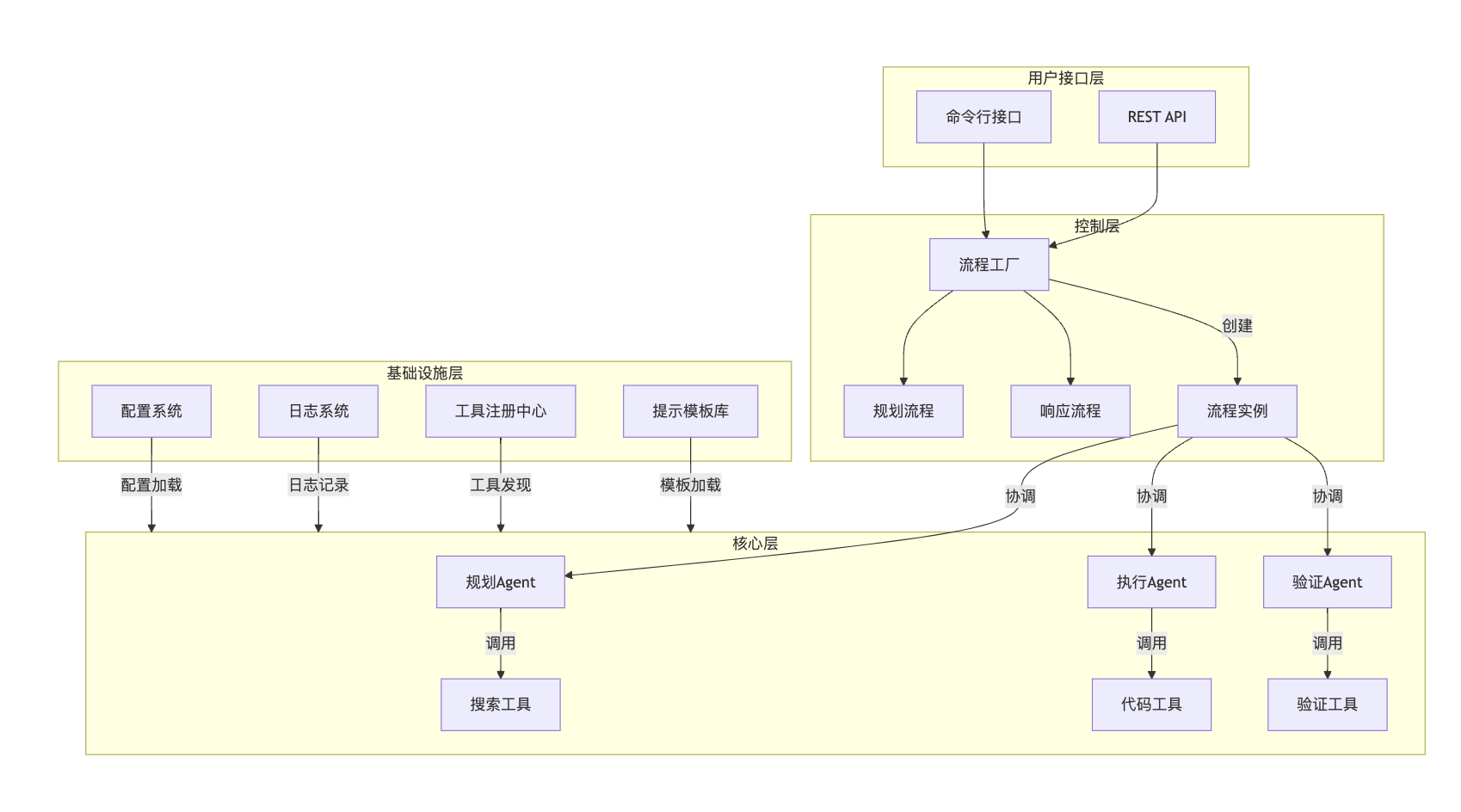

价格方面,DeepSeek-V2 API的定价为:每百万tokens输入1元、输出2元(32K上下文),价格为GPT-4-Turbo的近百分之一。

![图片[3]-DeepSeek 发布全球最强开源 MoE 模型-趣考网](https://oss.q2k.com/article/2024/05/08/203534545.jpg)

各大模型API价格对比

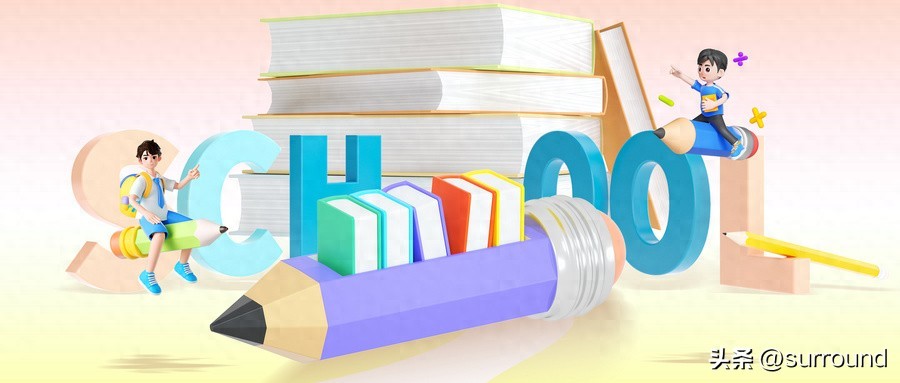

就中文能力来看,DeepSeek-V2在全球模型中处于第一档的位置,但其成本却是最低的(下图)。

![图片[4]-DeepSeek 发布全球最强开源 MoE 模型-趣考网](https://oss.q2k.com/article/2024/05/08/203534546.jpg)

横轴为每百万输入/输出Tokens平均单价

模型&论文双开源

DeepSeek-V2模型和论文完全开源,免费商用,无需申请:

模型权重:

https://huggingface.co/deepseek-ai

技术报告:

https://github.com/deepseek-ai/DeepSeek-V2/blob/main/deepseek-v2-tech-report.pdf

© 版权声明

本文中引用的各种信息及资料(包括但不限于文字、数据、图表及超链接等)均来源于该信息及资料的相关主体(包括但不限于公司、媒体、协会等机构)的官方网站或公开发表的信息。部分内容参考包括:(百度百科,百度知道,头条百科,中国民法典,刑法,牛津词典,新华词典,汉语词典,国家院校,科普平台)等数据,内容仅供参考使用,不准确地方联系删除处理!

THE END